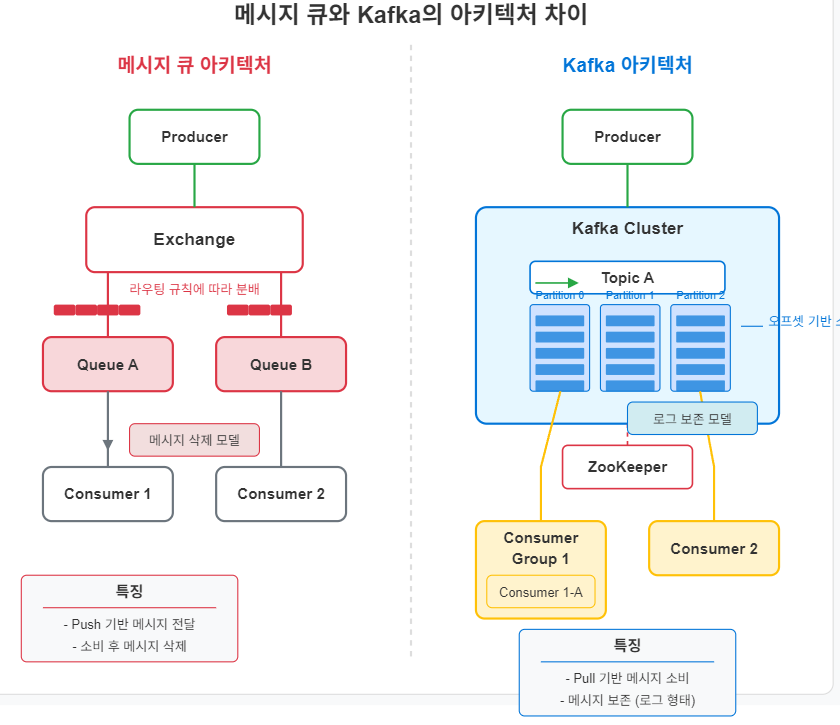

이 글에서는 전통적인 메시지 큐(RabbitMQ, ActiveMQ 등)와 Apache Kafka 간의 핵심적인 차이점을 살펴봅니다. 아키텍처, 성능, 활용 사례, 데이터 처리 방식 등 여러 측면에서 두 시스템을 비교하여 각각 어떤 상황에서 더 적합한지 이해할 수 있도록 도와드립니다.📌 메시지 큐와 Kafka: 개념 비교메시지 큐와 Kafka는 모두 애플리케이션 간 비동기 통신을 지원하는 미들웨어지만, 근본적인 설계 철학과 목적에 차이가 있습니다. ✅ 메시지 큐(Message Queue)란?애플리케이션 간 메시지를 전달하는 중간 저장소 역할주로 작업 부하 분산, 비동기 처리, 시스템 간 결합도 감소를 위해 설계AMQP(Advanced Message Queuing Protocol)와 같은 표준 프로토콜 기..